Kategorie: Datenqualität

Schlechte Datenqualität – Symptom oder die Ursache von Problemen?

Data Lake, Data Lake House, Data Ware House, Datenarchitektur, Datenkatalog, Datenqualität, Metadatenmanagement

Datenkatalog, Datenkompetenz, Datenqualität, Metadatenmanagement

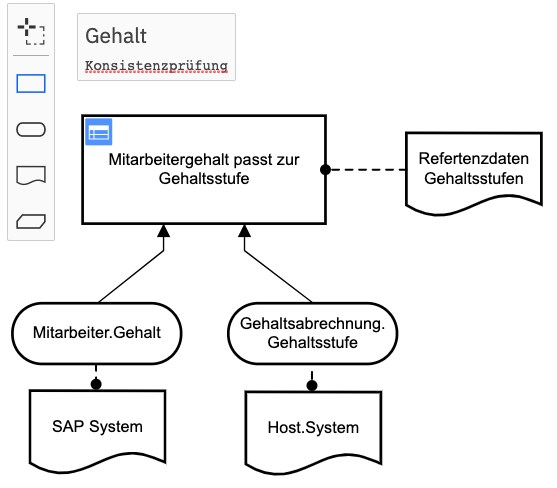

Letzte Tage hatte ich ein Gespräch mit den BI-Verantwortlichen einer mittelständischen Versicherung. Grund des Gesprächs war, dass der Kunde sowohl einen Data Lake für seine Analytics Projekte als auch ein Datawarehouse für diverse Reports nutzt und insbesondere bei Kundeninformationen/-daten es immer wieder zu abweichenden Ergebnissen aus den beiden Systemen kommt. Ein bei dem Gespräch anwesender […]

mehr

Gerne wird im Datenmanagement die Rolle des Data Stewards als sehr wichtig bezeichnet. Nun ist der Begriff „Steward“ im deutschen Sprachgebrauch eng mit Steward(essen) auf Kreuzfahrtschiffen und Passagierflugzeugen verwoben, die sich um das Wohl und die Sicherheit von Passagieren kümmern, dass sicherlich ein wichtiger Aspekt auch für Data Stewards ist (nur eben für Daten). Aber […]

mehr

Meine Systeme laufen auch mit schlechten Daten

Datenarchitektur, Datenkatalog, Datenkompetenz, Datenqualität, Metadatenmanagement

Datenqualität

Die schnelle Einführung von Datenqualitätsprojekten führt nicht zu höherer Datenqualität, sondern zu höheren Kosten und frustrierten Mitarbeitern.

Projekte zur Verbesserung der Datenqualität werden nicht strategisch angegangen, sondern sind zu häufig Reaktionen auf Datenpannen. Es regiert der Aktionismus und es müssen schnell „Quick Wins“ präsentiert werden, die nur kurzfristige Augenwischerei sind, aber mittelfristig nicht zu stabileren Geschäftsprozessen oder gar besseren Entscheidungen führen.

Wird Datenqualität nicht strukturiert eingeführt und mit Ressourcen unterlegt, schlafen die Initiativen schnell wieder ein und haben ausser hohen Kosten nichts erreicht.

mehr

Im Datenmanagement ist einer der elementaren Begriffe, der der Datenqualität. Beispiele für schlechte Datenqualität kennt und erlebt jeder: Auch die Auswirkungen schlechter Datenqualität in Unternehmen sind bekannt: Aber die Definition der Datenqualität fällt uns dennoch schwer. In diesem Beitrag beleuchten wir den Begriff aus sprachlicher Sicht, um einmal einen anderen Blickwinkel als das allgemein genutzte […]

mehr

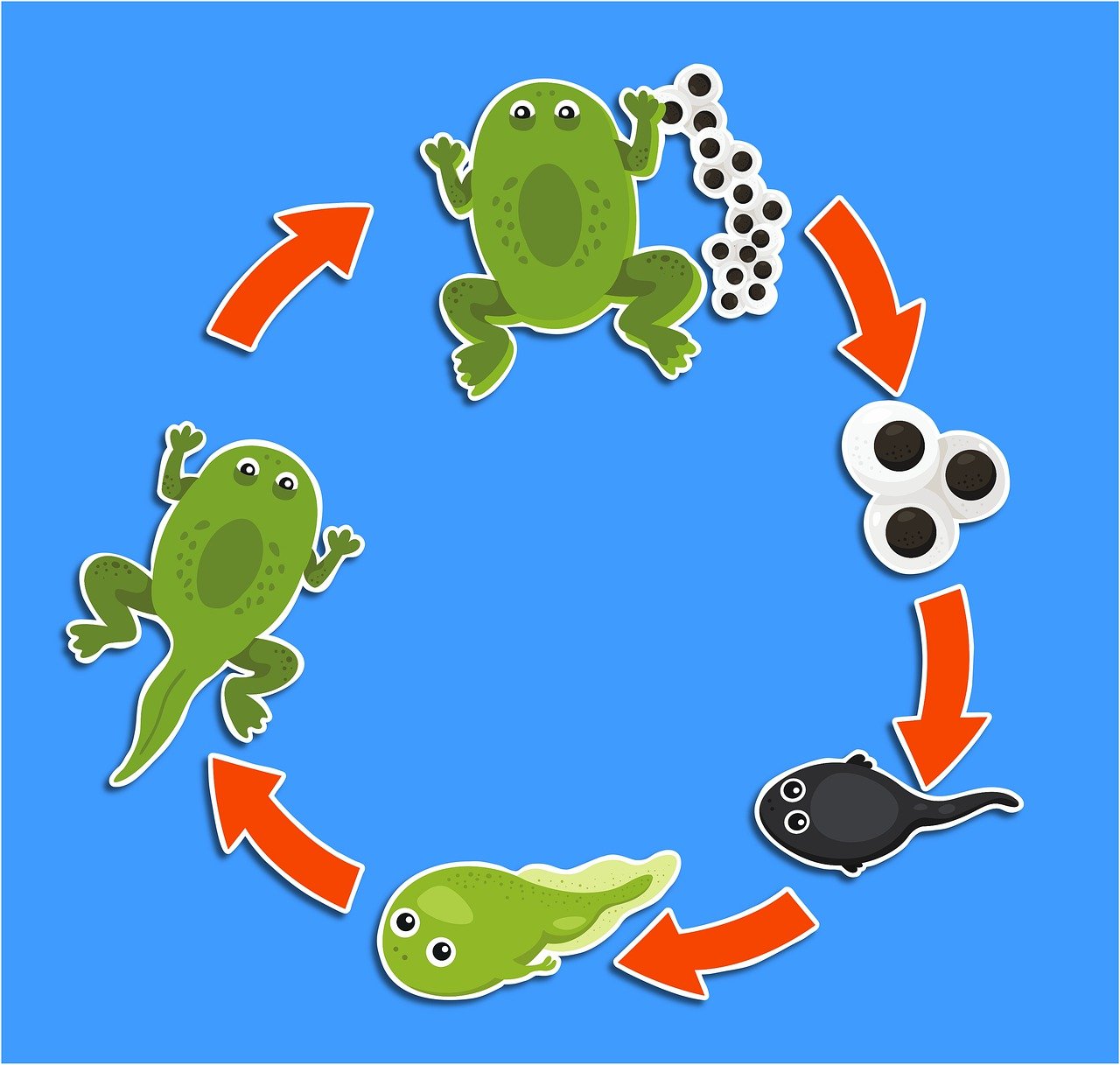

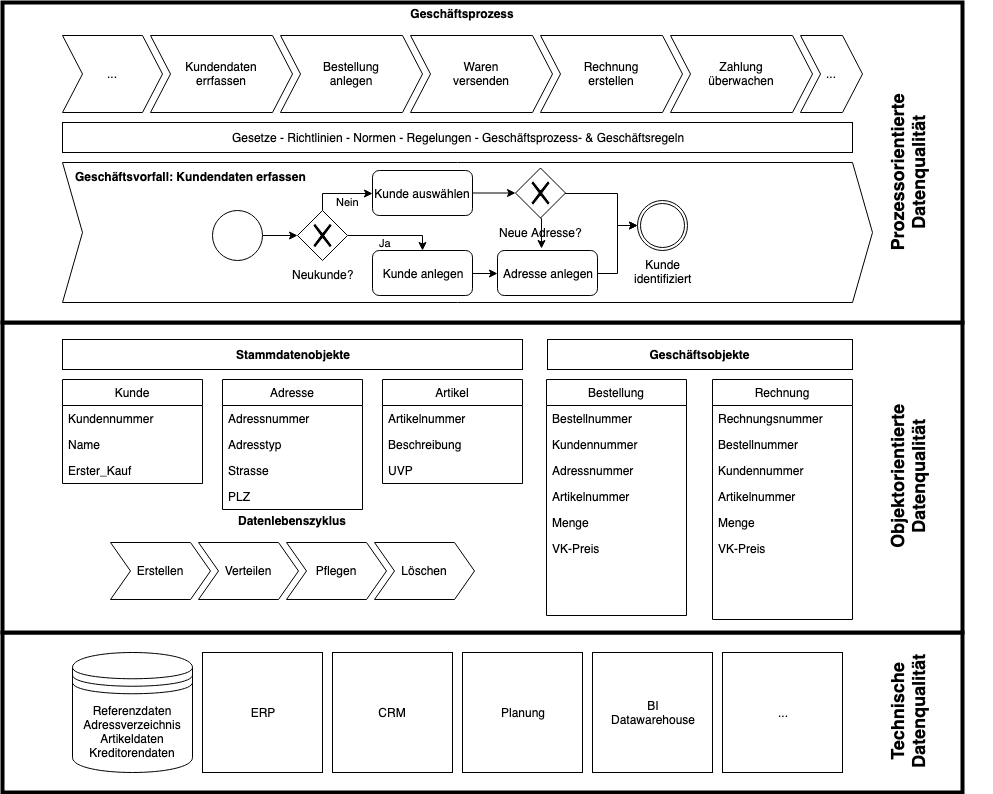

Obwohl im Deutschen der Ausdruck Elektronische Datenverarbeitung (EDV) oft synonym für IT benutzt wird, haben Applikationen und Prozesse in den letzten 30 Jahren eine viel höhere Aufmerksamkeit ind er IT erhalten, als das Thema Datenmanagement. Erst in den lezten Jahren – vielleicht auch bedingt durch das Lehrgeld, das Unternehmen für wirkungslose BI-Initiativen gezahlt haben – ist das Thema Datenmanagement stärker in den Fokus gerückt. In diesem Blogbeitrag wollen wir uns mit der Beziehung von Daten, insbesondere dem Datenlebenszyklus, und Prozessen beschäftigen.

mehr

Prozessorientiertes Datenqualitätsmanagement

Datenqualität, Werkzeug

Datenqualität, Metadatenmanagement

Datenqualität in Geschäftsprozessen Die Bedeutung einer hohen Datenqualität herrscht heute Einigkeit. Auch die Notwendigkeit von Datenqualität für die Durchführung von Geschäftsprozessen wird allgemein anerkannt. Jedoch befassen sich die Unternehmen immer noch überwiegend damit die Daten in ihren Reporting und Business Intelligence Applikationen zu verbessern an statt die Probleme dort anzugehen, wo sie auftreten – in […]

mehr

»Eine hohe Datenqualität ist die Grundlage für korrekte Entscheidungen«, »Eine hohe Datenqualität ist wichtig für unterbrechungsfreie Geschäftsprozesse« »Ohne Daten keine Digitalisierung«. Kein Unternehmen wird diesen Mantren widersprechen aber dennoch investieren die wenigsten Unternehmen in ein Datenmanagement Programm. Während eines BBQs diskutierte ich darüber mit einem Bekannten, COO eines internationalen Life Science Konzerns, und seine Antwort […]

mehr

Weil Datenqualität noch vorrangig als IT-Thema betrachtet wird, starten Projekte regelmässig mit der Auswahl einer Softwarelösung. Ansätze, die aus einem solchen Aktionismus „Wir müssen unsere Datenqualität steigern“ entstehen, können zwar kurzfristig die Datenqualität steigern, aber fast nie die Datenqualität dauerhaft halten.

mehr

In den letzten Jahren gab es einige Anläufe um Entscheidungen und die Entscheidungsfindung zu formalisieren, automatisieren und nachvollziehbar zu dokumentieren. Obwohl diese Ziele sehr überzeugend sind, konnten sich IT- Lösungen, in Unternehmen nicht durchsetzen, da sie als zu isoliert – nicht mit bereits verwendeten Lösungen und Methoden verwendbar – oder als zu akademisch empfunden worden […]

mehr